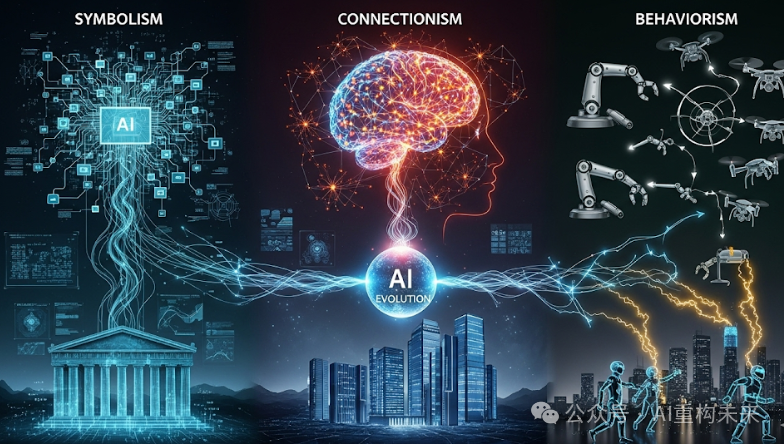

人工智能三大流派的演进历程

• 符号主义:以逻辑规则和符号操作为核心,试图通过“自上而下”的方式构建智能。它在早期AI(如专家系统)中占据主导地位,强调推理的透明性和可解释性。然而,在处理现实世界的复杂性、不确定性和大规模数据时,符号主义面临挑战,并因过度依赖人工编写规则而逐渐陷入低谷。

• 联结主义:则秉持“自下而上”的路线,受到人类大脑神经元结构的启发。它通过人工神经网络从海量数据中学习模式,尤其在21世纪随着GPU计算能力和大数据(如ImageNet)的推动下,深度学习取得了图像识别、语音识别和自然语言处理(如ChatGPT)等领域的革命性突破。尽管联结主义在感知和模式识别方面表现出色,但也因其“黑箱”特性和解释性不足而受到批评。

• 行为主义:则将智能视为与环境互动中“做”出来的结果,而非预设规则或内部机制。其主要代表是强化学习,通过奖励与惩罚机制,智能体在与环境的交互中不断优化策略,在游戏(如AlphaGo)和机器人控制领域取得显著进展。

当前,这些流派并非孤立,而是呈现出深度融合的趋势,以克服各自的局限。这种融合将推动AI走向更智能、更可靠、更贴近人类认知的通用人工智能(AGI),深刻影响未来的科技与生活。

一、符号主义:逻辑的殿堂与规则的艺术

假设你正在玩一盘国际象棋。每一步棋,你都依据棋子的走法规则、对局面的判断,以及预设的策略来推演。机器的“思考”也能如此清晰、有章可循吗?符号主义(Symbolic AI),正是基于这种将智能视为符号操作和逻辑推理的哲学观念。

1、核心思想:像人类思考那样,把一切理清楚

符号主义者们相信,人类的智能活动,无论是解决问题、理解语言,还是做出决策,都可以被分解成一套套明确的符号(Symbol)逻辑规则(Logical Rules)。这些符号就像我们思维中的一个个概念——“人”、“猫”、“飞翔”、“如果…那么…”——而规则则定义了这些概念之间如何关联、如何推导。

在这种观念下,机器的“大脑”就像一个巨大的逻辑图书馆。图书馆里存放着海量的“知识卡片”(符号)和“推理指南”(规则)。当机器遇到一个问题,它就会按照“推理指南”的指示,从“知识卡片”中找到相关信息,一步步地推导出结论。它的每一个决策过程都清晰可见,可以像数学证明一样被追踪和解释。

2、起源与演进史:从哲学思辨到机器实践

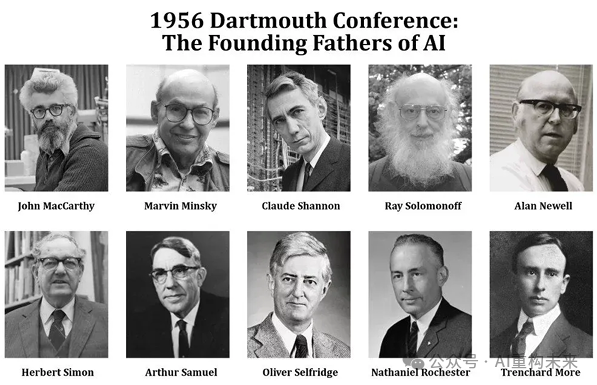

符号主义的种子,早在20世纪50年代的AI萌芽时期就已埋下。1956年的达特茅斯会议上,“人工智能”这一激动人心的术语被正式提出,奠定了AI作为一个独立学科的基石。

那时,一批富有远见的科学家,如艾伦·纽厄尔(Allen Newell)、赫伯特·西蒙(Herbert Simon)和克利夫·肖(Cliff Shaw),就致力于构建能模拟人类思维过程的计算机程序。1957年,他们开发的逻辑理论家(Logic Theorist,被广泛认为是第一个人工智能程序,该程序通过模拟证明定理所涉及的推理过程证明了38条数学定理,确认了机器可以进行逻辑推理和解决问题,展示了机器执行复杂认知任务的潜力)和通用问题求解器(General Problem Solver, GPS),就像机器版的“思想家”,尝试用符号逻辑来证明数学定理、解决各种问题。另一位关键人物,约翰·麦卡锡(John McCarthy),则发明了LISP编程语言,为符号操作提供了强大的工具。

艾伦·纽厄尔和赫伯特·西蒙

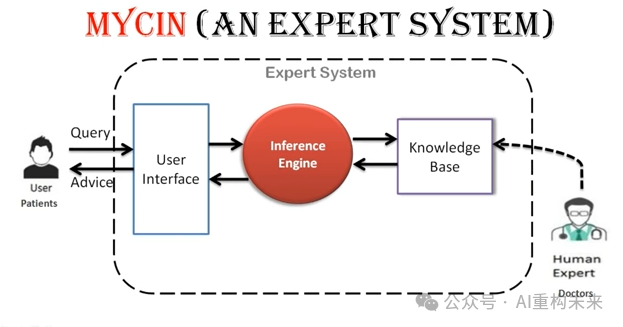

在20世纪60至90年代,符号主义迎来了它的黄金时代。其中最成功的应用之一便是专家系统(Expert Systems)。这些系统能够汲取人类专家的知识,将其编码成大量的“如果…那么…”规则,在特定领域(如医疗诊断、地质勘探)提供专业建议,甚至表现出超越普通人的能力。著名的MYCIN医疗诊断系统和XCON计算机配置系统就是这一时期的代表。

1997年,IBM超级计算机“深蓝”通过蛮力计算能力(使用 32 个处理器并行执行一组协调的高速计算。深蓝每秒评估 2 亿个国际象棋位置,实现每秒 113.8 亿次浮点运算或翻牌的处理速度)战胜国际象棋世界冠军卡斯帕罗夫让符号主义名声大震。

然而,现实世界充满了复杂性和不确定性,而符号主义过于依赖精确的规则。当遇到“例外”或模糊情境时,它就显得束手无策。例如,“鸟会飞”这个规则,遇到企鹅或鸵鸟时就会“失效”。知识获取瓶颈(Knowledge Acquisition Bottleneck)——即从人类专家那里获取并手工编码海量知识的巨大耗费和难度——也成为了它的阿喀琉斯之踵。这些局限,其后续发展逐渐式微。

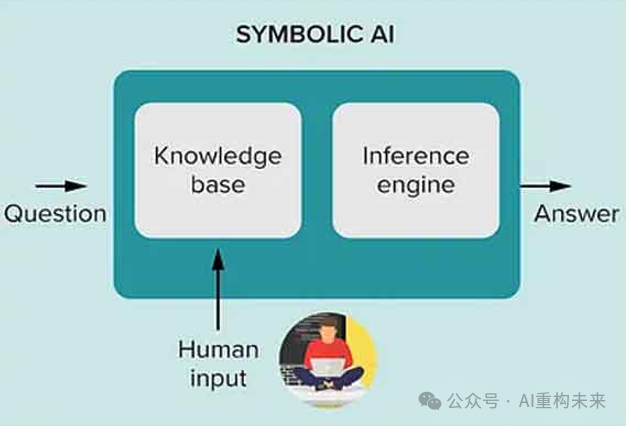

3、主要组件:知识的“图书馆”与推理的“向导”

一个典型的符号主义系统包含以下几个关键部分:

1)知识库(Knowledge Base):这是一个由人类专家构建的“知识宝典”,包含了大量的事实、概念和“如果/那么(if/then)”规则。这些规则告诉算法在特定条件下应该如何行动。例如,在医疗诊断系统中,知识库会存储各种疾病的症状和诊断标准。

2)推理引擎(Inference Engine):这个组件就像知识库的“大脑”,它会根据知识库中的规则,对给定的符号进行逻辑推理,从而得出新的结论或解决问题。它可以进行正向链(Forward Chaining)(从事实推导结论)或反向链(Backward Chaining)(从目标倒推所需事实)。

3)符号(Symbols):构成机器“思考”的基石,可以是文字、数字、概念,甚至是我们对真实世界的抽象。它通过层级、列表或网络等方式组织字符串,代表现实世界的实体或概念。

4、适用场景:规则清晰的“专家”领域

符号主义在那些规则清晰、目标明确的领域表现卓越:

1)医疗诊断:分析症状、参照医学知识,提供诊断建议。

2)法律分析:处理法律条文、合同风险评估。

3)金融合规:核查交易、确保符合法规。

4)自动化办公:处理基于规则的重复性任务,如文件分类、发票管理。

5)数字助手:理解我们发出的清晰指令。

5、优势与劣势:透明与严谨,但不够灵活

1)主要优势:

• 可解释性强(Interpretability):由于每一步推理都有明确的规则支持,机器可以清楚地解释它为何做出某个决定,这在需要高度透明和可信赖的领域(如医疗、法律)至关重要。

• 知识表示结构化(Structured Knowledge Representation):知识被清晰、有条理地组织,易于人类理解和修改。

• 逻辑推理精准(Precise Logical Reasoning):在规则明确的框架内,能进行严密的逻辑推导。

• 数据依赖小(Low Data Dependency):不需海量数据即可运行。

2)主要劣势:

• 知识获取困难(Knowledge Acquisition Bottleneck):手工编码知识成本高昂且耗时。

• 适应性差(Poor Adaptability):难以处理模糊、不确定或超出预设规则的现实世界情境。

• 可伸缩性差(Scalability Issues):随着规则和符号的增多,系统会变得异常复杂和难以管理。

• 通用性弱(Weak Generalization):对未曾预见的变数非常“脆弱”,很难举一反三。

6、现况与未来趋势:在融合中焕发新生

如今,纯粹的符号主义已不再是AI的主流,但它并未消亡。在需要可解释性和结构化知识的特定领域,如知识图谱、法律辅助系统等,符号主义仍发挥着重要作用。

更有趣的是,符号主义正在与新兴的联结主义深度融合,形成神经符号人工智能,力求结合两者的优势,共同迈向更强大的智能。这让它在未来的AI发展中,有望焕发新的生命力。

二、联结主义:大脑的仿生与模式的魔力

1、核心思想:从“经验”中学习模式

联结主义的核心思想:智能并非来源于预设的逻辑规则,而是通过大量简单单元(人工神经元)之间的连接和学习过程“涌现”出来的。

在这个模式下:

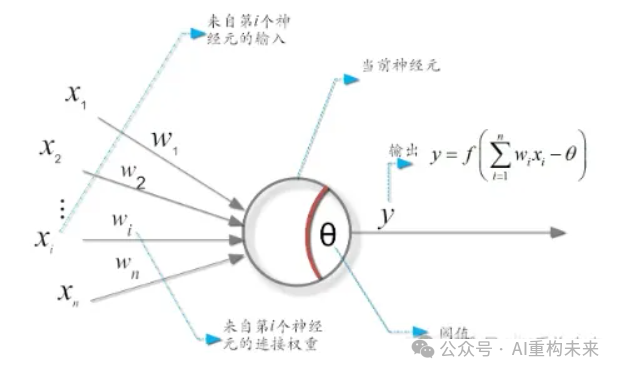

• 神经元是信息处理单元:每个神经元接收多个输入,经过加权求和并通过一个“激活函数”产生一个输出。

• 连接权重存储知识:神经元之间的连接具有不同的“权重”,这些权重衡量了它们之间信号传递的重要性。知识不是存储在某个特定位置,而是以分布式的形式编码在整个网络的连接权重中。

• 学习是权重的调整:系统通过不断地接触数据,根据其预测的准确性,自动调整神经元之间的连接权重,从而识别数据中的模式和关系。

联结主义系统不是被明确编程的,而是通过大量的数据“经验”来学习。就像一个孩子通过看成千上万张猫的图片,而不是通过背诵“猫有四条腿、会喵喵叫”的规则,来学会识别猫一样。在学习过程中,网络会根据其预测的准确性不断调整神经元之间的连接权重,从而逐渐发现数据中隐藏的模式和规律,变得越来越“聪明”。这种学习方式也被形象地称为“并行分布式处理(Parallel Distributed Processing, PDP)”。

2、起源与演进史:几经沉浮的探索之路

1)第一波浪潮(20世纪40-60年代):

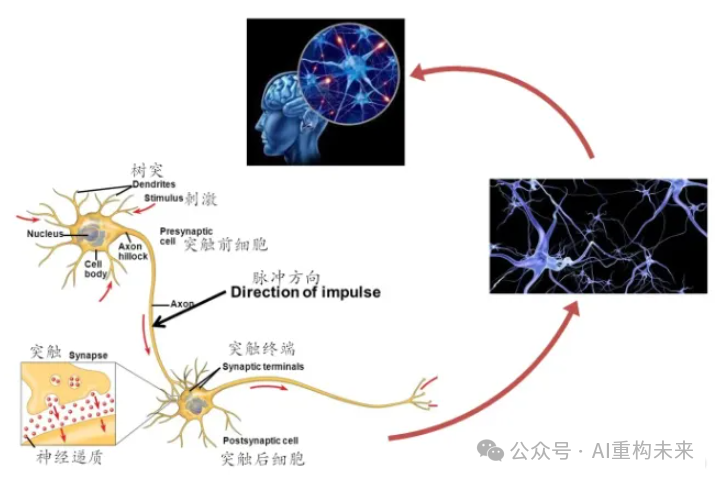

• 1943年,美国神经生理学家沃伦·麦卡洛克(Warren McCulloch)和数学家沃尔特·皮茨(Walter Pitts)提出首个通过模仿神经元而形成的“M-P神经元模型”,对生物大脑的极度简化,描述了神经元在大脑中的信息处理方式,构建了神经网络研究的基础,开创性地将神经元的活动形式化为数学逻辑和计算模型,把大脑视为与计算机一样的存在,神经细胞有两种状态:兴奋和不兴奋(即抑制),可利用数字计算机中的一系列0和1进行模拟。通过把简化的二进制神经元连成链条和链环,并阐明了大脑能实现任何可能的逻辑运算,也能完成任何图灵机可以完成的计算,为后来的人工智能研究、神经网络和计算神经科学的发展奠定了理论基础,是人工智能领域的早期奠基性工作之一。

大脑神经细胞工作流程

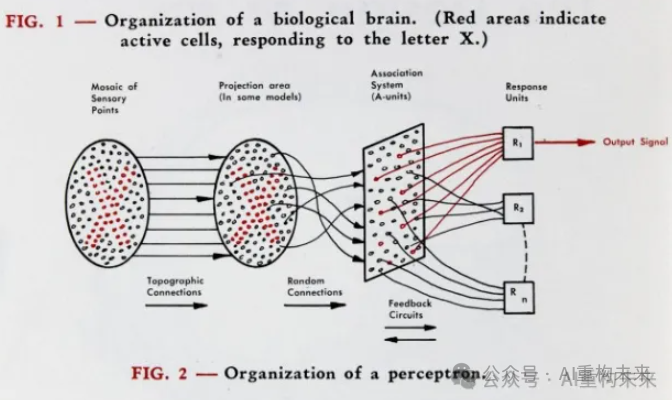

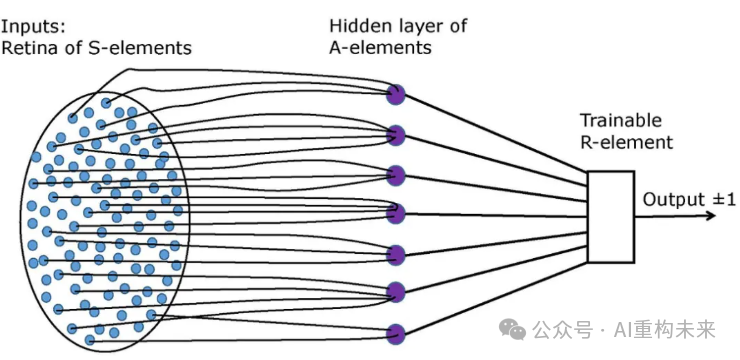

• 1958年,弗兰克·罗森布拉特(Frank Rosenblatt)利用“M-P神经元模型”提出了感知机(Perceptron)模型,这是最早的人工神经网络模型之一,能够通过简单的数学运算实现学习和分类任务,从而为后续的人工智能和机器学习研究奠定了基础。感知机通过权重调整来学习输入特征与输出之间的关系,展示了神经网络的基本工作原理。尽管该模型在处理线性可分问题上表现出色,但在面对非线性问题时存在局限性。Rosenblatt的工作激发了对更复杂神经网络的研究。感知机模型成功应用于线性可分的模式识别问题求解,后续还研制了用硬件实现感知机原理的神经计算机,从而开创了模仿大脑神经系统的人工智能联结主义学派。

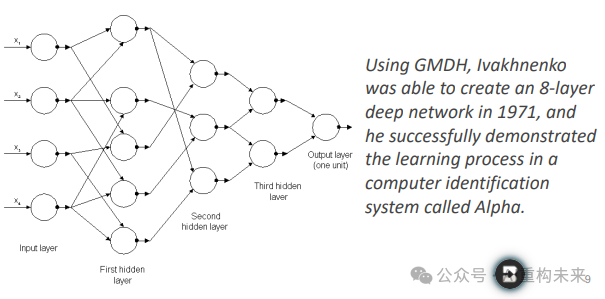

• 1965年:阿列克谢·伊瓦赫年科(Alexey Ivakhnenko) 创建了神经网络的层次表示,使用多项式激活函数并通过数据处理组方法 (GMDH) 进行训练。这被认为是第一个多层感知器。

• 然而,1969年,马文·明斯基(Marvin Minsky)和西摩·帕珀特(Seymour Papert)出版《感知器》一书,书中提出,单层感知器无法解决诸如奇偶校验和连通性等更复杂的问题。这一结论在一定程度上削弱了当时对感知器未来的乐观情绪,并导致了对基于感知器的研究的冷却。将人工智能研究推入了冬天。

2)第二波浪潮(20世纪80年代中期):

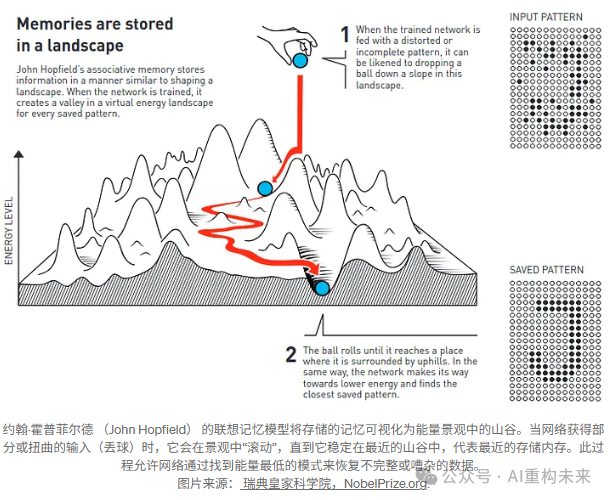

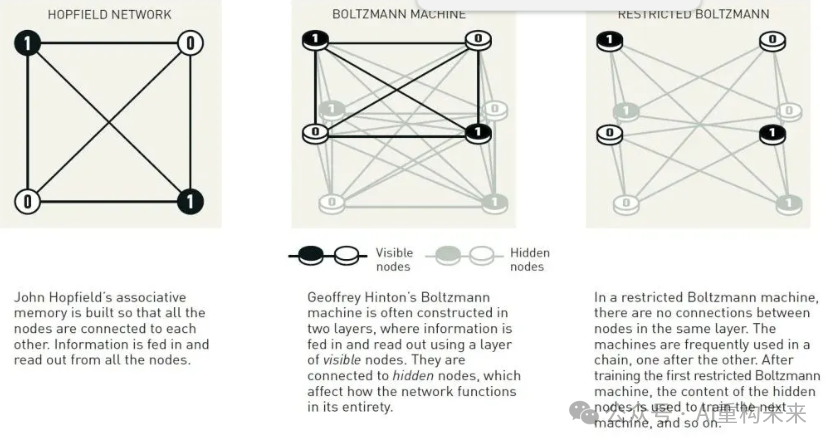

• 对神经网络的兴趣在80年代中期重新燃起。约翰·霍普菲尔德(John Hopfield)创建了Hopfield网络,通过引入能量函数来模拟联想记忆。对现代深度学习时代的循环神经网络(RNN)模型至关重要。因该成就约翰·霍普菲尔德获得2024年诺贝尔物理学奖。

• 1985年:Geoffrey Hinton、Terrence Sejnowski和David H. Ackley提出了玻尔兹曼机(Boltzmann Machines),它是一种随机递归神经网络,使用概率方法来建模数据分布,由一组相互连接的神经元组成,每个神经元可以取二值状态(0 或 1)。这些网络属于能量模型,通过最小化能量函数来学习。玻尔兹曼机主要用于无监督学习、特征提取和复杂的优化问题。

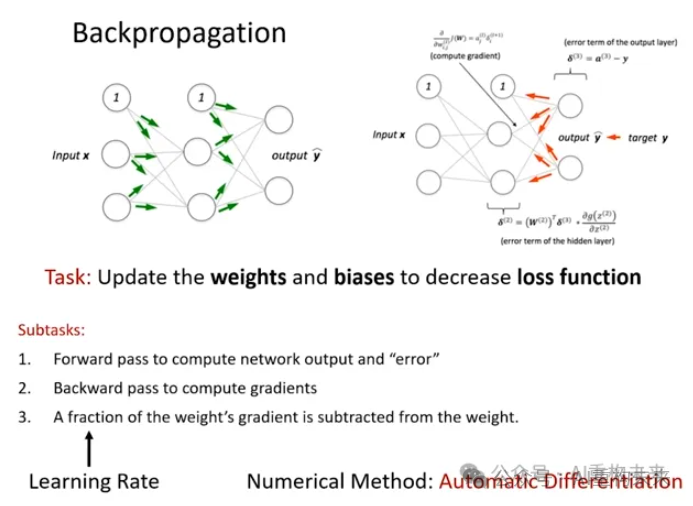

• 1986年,戴维·鲁梅尔哈特(David Rumelhart)、杰弗里·辛顿(Geoffrey Hinton)和罗纳德·威廉姆斯(Ronald J. Williams)提出了一种用于训练神经网络的反向传播算法(Backpropagation),反向传播算法建立在梯度下降法的基础上,梯度下降法通过计算损失函数的梯度,并将这个梯度反馈给最优化函数来更新权重以最小化损失函数,这是神经网络领域的关键突破。通过反向传播,神经网络可以反复调整连接的权重以最小化误差函数,它根据在前一个 epoch (即迭代) 中获得的误差率 (即损失) 微调神经网络权重的做法。适当调整权重可确保降低错误率,通过提高模型的泛化性使模型可靠。反向传播的提出为深度学习的突破奠定了基础。反向传播算法广泛用于在深度学习等领域训练前馈神经网络。

• 1989年,杨立昆(Yann LeCun)使用反向传播训练卷积神经网络(Convolutional Neural Network, CNN)识别手写数字,这是现代计算机视觉使用深度学习的突破性基础。

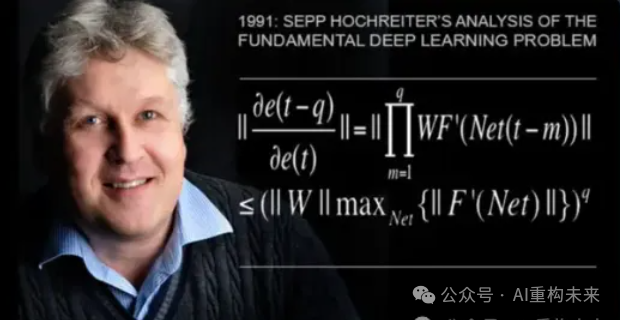

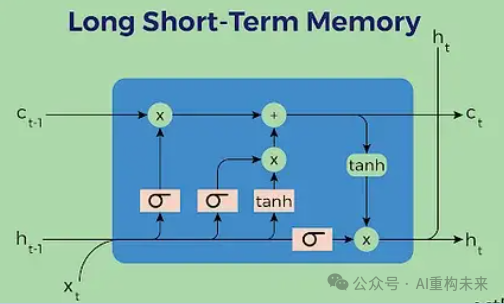

◦1997年,于尔根·施密德胡伯(Jürgen Schmidhuber) 和塞普·霍赫赖特(Sepp Hochreiter) 提出了一种解决序列学习问题的创新神经网络架构,称为长短时记忆网络LSTM神经网络,克服了传统递归神经网络(RNN)在处理长时间依赖时遇到的梯度消失和梯度爆炸问题。LSTM通过引入“遗忘门”、“输入门”和“输出门”等门控机制和常数误差循环,克服了传统RNN在长时间依赖学习中的局限性,奠定了序列学习领域(如语音识别、翻译等)的重要基础。

Jürgen Schmidhuber

Sepp Hochreiter

另外,Yoshua Bengio在神经网络理论和模型上的持续创新、李飞飞在构建大规模数据集ImageNet方面的贡献,以及黄仁勋通过GPU技术提供的强大计算能力,共同为联结主义在21世纪的“第三波浪潮”和深度学习的“黄金时代”奠定了坚实的基础,

3)第三波浪潮(21世纪10年代至今):

• 进入21世纪,随着计算能力提升(尤其是GPU的崛起)和大规模高质量数据集出现(如李飞飞教授的ImageNet),深度神经网络的训练变得可行,深度学习(Deep Learning)进入爆发期。

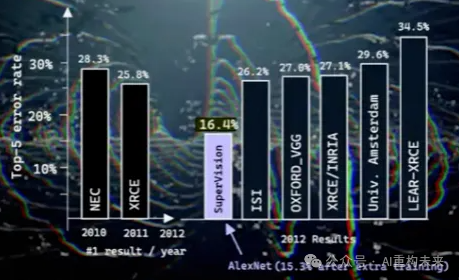

• 2012年,亚历克斯·克里日夫斯基(Alex Krizhevsky)、伊利亚·苏茨克维(Ilya Sutskever)和杰弗里·辛顿提出的AlexNet模型在ImageNet图像识别大赛中大获全胜,错误率远超传统方法,标志着深度学习正式走向主流,掀起了新一波AI浪潮。

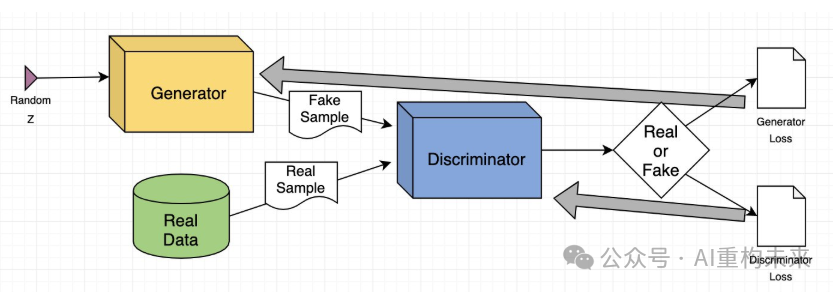

• 2014年,伊恩·古德费洛(Ian Goodfellow)和其导师约书亚·本吉奥(Yoshua Bengio)等提出了生成对抗网络(Generative Adversarial Networks,GANs),开创了深度生成模型的新范式。GAN由一个生成器(Generator)和一个判别器(Discriminator)组成,二者通过对抗训练的方式相互提升,从而实现了对高维数据的生成和模拟。GAN的提出不仅极大地推动了生成模型的发展,而且在图像生成、风格转换、数据增强等多个领域取得了令人瞩目的成果,成为现代生成模型的基石之一。

Yoshua Bengio

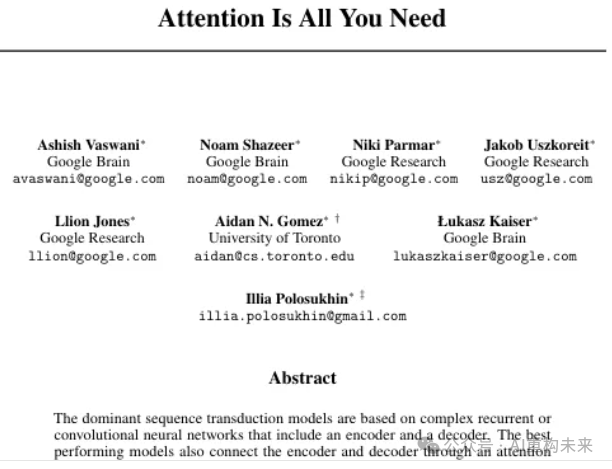

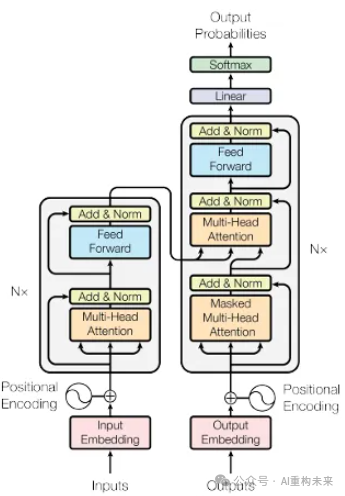

• 2017年,Vaswani等人在2017年提出了Transformer架构,引入自注意力机制,彻底改变了自然语言处理,摆脱了序列限制。这为GPT、BERT等大语言模型(LLM)的爆发奠定了基础。

• 2022年,ChatGPT的横空出世,以其惊人的语言理解和生成能力,让全球见证了深度学习的巨大潜力,成为人工智能发展史上又一个里程碑。ChatGPT等模型的出现,让联结主义技术走入大众视野。

3、主要组件:像大脑一样的“网络”结构

1)人工神经元(Artificial Neuron/Unit):网络中的基本处理单元,模拟生物神经元的功能,接收输入、计算,并产生输出。

2)连接与权重(Connections and Weights):神经元之间的连接通道,每个连接都有一个“权重”,代表着信息传递的重要性或强度。这些权重在学习过程中不断调整。

3)层(Layers):神经元通常组织成多层结构,包括接收信息的输入层、进行复杂处理的隐藏层,以及产生最终结果的输出层。

4)激活函数(Activation Function):决定一个神经元是否“兴奋”并向下一个神经元传递信号的规则。

5)反向传播算法(Backpropagation):一种核心的学习算法,通过计算输出错误并将其逐层“反向传播”回网络,来调整所有连接的权重,从而减少错误。

6)训练数据(Training Data):高质量、大量的训练数据是联结主义系统变得智能的基础。

4、适用场景:海量数据中的“模式发现者”

1)图像识别:人脸识别、物体检测、医疗影像分析。

2)语音识别:智能语音助手、语音转文本。

3)自然语言处理(NLP):机器翻译、文本生成、情感分析、智能问答。

4)自动驾驶:通过摄像头数据感知环境、识别障碍物。

5)金融预测:分析市场数据、预测趋势。

5、优势与劣势:强大的学习能力,但难以解释

1)主要优势:

• 强大的模式识别能力(Strong Pattern Recognition):擅长从复杂、非结构化的海量数据中(如图像、声音、文本)发现隐藏的模式和关联。

• 自主学习与适应性(Autonomous Learning and Adaptability):能够通过“经验”自动学习,无需人类明确编程每条规则,并能适应新环境和新数据。

• 泛化能力强(Strong Generalization):能从已学到的知识中举一反三,处理前所未见的新情况。

• 容错性(Graceful Degradation):即便网络局部受损,系统通常仍能保持一定功能,这与人类大脑的特性相似。

2)主要劣势:

• “黑箱”问题(Black Box Problem):由于知识分散存储在数百万甚至数十亿个权重中,很难解释机器为什么会做出某个决策或得出某个结论。这在需要高度透明度的领域是一个严峻挑战。

• 数据饥渴(Data Hunger):需要巨量且高质量的训练数据才能达到良好性能。数据不足或质量不高会严重影响学习效果。

• 计算资源需求高(High Computational Requirements):训练大型神经网络需要强大的计算能力(如GPU)和巨大的能源消耗。

• 缺乏常识推理(Lacks Common Sense Reasoning):在纯粹的逻辑推理、因果关系理解和人类常识方面,联结主义系统仍显不足。

6、现况与未来趋势:当仁不让的“AI主角”

目前,联结主义无疑是AI领域最活跃、最具统治力的流派。它支撑着大语言模型(如GPT系列、DeepSeek系列)、计算机视觉、语音识别和生成式AI(如AI绘画、视频生成)等一系列前沿技术。

未来,联结主义将继续神话发展,但会更加注重:

1)与符号主义的融合(神经符号AI):解决“黑箱”问题,注入常识和逻辑推理能力。

2)效率与能耗优化:通过模型压缩、稀疏模型和新型计算硬件(如量子计算)来降低能源消耗和计算成本。

3)多模态模型:整合文本、图像、语音等多种信息模态,让AI能够更全面地理解世界。

4)无监督/自监督学习:让模型能够从无标签数据中进行更有效的学习。

5)神经科学启发:更深入地从生物大脑中汲取灵感,开发类脑芯片和脉冲神经网络。

三、行为主义:智能源于行动与互动

如果说符号主义是“思考”,联结主义是“感知”,那么行为主义(Behaviorism/Actionism)智能不是借助预设规则或依赖神经网络的内部机制,而是体现在与环境的交互中,通过不断地尝试和反馈来学习如何行动。换句话说,智能是“做”出来的,而不是“想”出来的。

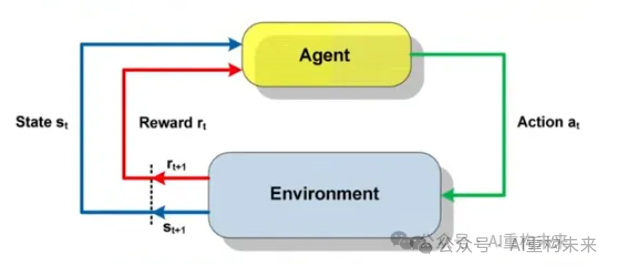

行为主义的核心观点是:智能通过智能体(agent)与环境的持续交互来学习和展现。

1)智能体:一个能够感知环境状态并采取行动以实现特定目标的人工智能实体。

2)试错学习(Trial-and-Error Learning):智能体在环境中采取行动,然后根据环境给予的“奖励”或“惩罚”来调整自己的行为策略。

3)刺激-反应:智能体的行为更多地是对环境刺激的直接反应,而非复杂的内部规划。

4)涌现行为:复杂的智能行为,可以从少数简单的行为规则相互作用中“涌现”出来。

你可以把行为主义系统想象成一个正在学习走迷宫的孩子。你不需要给他一张迷宫地图或一套详尽的行走规则,你只需要告诉他:“走到出口有奖励,碰到墙壁有惩罚。”通过反复的尝试、碰壁、绕行,他最终会自己找到走出迷宫的最佳路线。

2、起源与演进史:从控制论到”棋王”

行为主义在AI中的影响相对较晚,但其思想源远流长。

1)控制论(1940s-1950s):诺伯特·维纳(Norbert Wiener)开创的控制论研究了系统如何通过反馈机制进行自我调节,这为行为主义打下了基础。

Norbert Wiener

2)反应式控制与具身智能(1980s):麻省理工学院的罗德尼·布鲁克斯(Rodney Brooks)提出行为主义人工智能 (Behavior-Based AI,又常称为新人工智能Nouvelle AI)和“分层架构”(Subsumption Architecture,用于控制移动机器人。将机器人控制分为多层:底层负责简单的反射行为,如避障,上层负责更复杂的行为,如探索、目标导向,是对传统中央控制—知识表示—推理规划模式的颠覆)。他明确反对符号主义构建复杂内部世界模型的做法,主张机器应该直接在真实世界中运作,并通过简单的反应模块叠加产生复杂的行为。他设计的机器人赫伯特(Herbert),能在办公室里寻找空可乐罐并回收,看似智能的行为正是由十几个简单的行为互动“涌现”出来的。

Rodney Brooks

3)强化学习作为独立领域发展:在20世纪80-90年代得到了理查德·萨顿(Richard S. Sutton)和安德鲁·巴托(Andrew G. Barto)的系统性阐述。他们的著作《强化学习:导论》成为了该领域的圣经。

Richard S. Sutton

Andrew G. Barto

4)强化学习与深度学习结合:进入21世纪10年代,当强化学习与联结主义的深度学习相结合,便催生了深度强化学习(Deep Reinforcement Learning, DRL),开启了行为主义的爆发式发展。

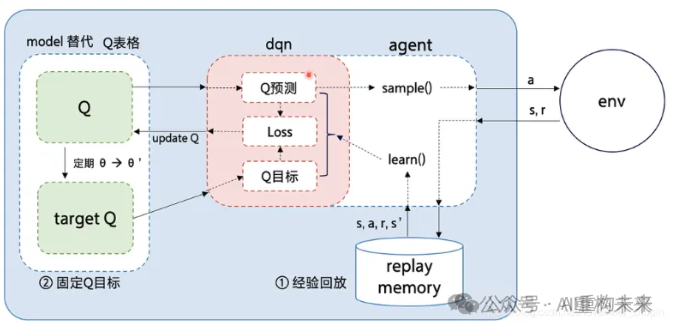

5)深度Q网络:2015年,DeepMind公司的沃洛德米尔·姆尼赫(Volodymyr Mnih)和戴维·席尔瓦(David Silver)深度Q网络(Deep Q-Network, DQN),让机器在多个雅达利(Atari)游戏中达到甚至超越人类水平。

6)AlphaGo战胜人类:2016年,戴维·席尔瓦(David Silver)领导的团队开发的AlphaGo,通过深度强化学习和蒙特卡洛树搜索,击败了世界围棋冠军李世石,这一事件震惊了世界,也彻底改变了人们对机器智能的认知。

3、主要组件:在环境中“摸爬滚打”的智能体

1)智能体(Agent):能够感知环境、执行行动并从中学习的机器。

2)环境(Environment):智能体所处的外部世界,它会根据智能体的行动给出反馈。

3)行动(Actions):智能体在环境中可以执行的操作。

4)状态(States):环境在某一时刻的特定情况。

5)奖励与惩罚(Rewards and Penalties):环境对智能体行动的反馈,正向激励(奖励)或负向抑制(惩罚),用于指导智能体学习。

6)策略(Policy):智能体在给定状态下选择何种行动的规则或模式。

4、适用场景:动态多变的“竞技场”

行为主义尤其适合动态、复杂、规则难以明确定义的环境:

1)游戏AI:下棋、玩电子游戏,如AlphaGo。

2)机器人控制:让机器人在真实世界中学习行走、抓取、导航等复杂动作。

3)自动驾驶:在复杂多变的交通环境中做出实时决策。

4)推荐系统:通过用户互动反馈优化推荐策略。

5、优势与劣势:自主学习与适应,但效率较低

1)主要优势:

• 自主探索与试错(Autonomous Exploration & Trial-and-Error):机器可以不依赖人类的预设知识,通过与环境的直接互动自主学习。

• 环境适应性强(Strong Environmental Adaptability):在面对未知或动态变化的环境时,能够灵活调整策略,表现出强大的适应能力。

• 处理复杂性(Handles Complexity):通过简单的规则互动,可以涌现出非常复杂的智能行为。

• 具身智能(Embodied Intelligence):强调在真实世界中的物理互动,这对于机器人等物理实体至关重要。

2)主要劣势:

• 学习成本高(High Learning Cost):机器往往需要进行海量的试错和互动才能学会最佳策略,这需要巨大的计算资源和时间。

• 数据效率低(Low Data Efficiency):通常需要大量的“经验数据”才能有效学习。

• 缺乏长远规划(Lacks Long-Term Planning):在需要抽象推理、长远规划或预测未来结果的任务上,行为主义系统仍有局限。

• 扩展复杂认知困难(Difficulty Scaling Complex Cognition):从简单的行为中涌现出类似人类的复杂认知仍是一个巨大挑战。

6、现况与未来趋势:具身智能的先行者

行为主义的思想,如今主要以强化学习和具身智能的形式活跃在AI前沿。它在机器人、游戏AI和自主智能体等领域取得了显著突破。例如,波士顿动力(Boston Dynamics)的机器人能够完成各种高难度动作,正是行为主义思想的体现。

未来,行为主义将继续探索如何提升学习效率(如模型驱动强化学习)、实现多智能体协作、以及在真实世界中进行更复杂的具身学习。它将继续作为构建能够在物理世界中灵活行动的智能机器的基石。

四、融合与未来:智能的交响曲

这三大流派,并非彼此孤立的岛屿,而是在AI历史的长河中不断碰撞、交融,甚至相互渗透的大陆。单一的流派往往难以应对所有智能挑战,而融合,才是通向通用人工智能(Artificial General Intelligence, AGI)的必由之路。

1、智能的交织:三大流派的融合

1)神经符号人工智能(Neuro-Symbolic AI):这是联结主义和符号主义的深度结合。它希望机器既能像联结主义那样感知世界、识别模式(如通过神经网络识别图像中的物体),又能像符号主义那样进行严密的逻辑推理,理解因果关系,并具有人类的常识(如通过符号系统推理物体之间的关系,解释决策过程)。这种融合的目标是弥补联结主义“黑箱”和“缺乏常识”的不足,同时解决符号主义知识获取的困难,让AI系统更强大、更透明、更具理解力。如今,大语言模型(LLMs)驱动的自主智能体(LLM-Empowered Autonomous Agents, LAAs),正是这种神经符号融合的生动实践。

2)深度强化学习(Deep Reinforcement Learning, DRL):这是联结主义与行为主义的完美结合。深度学习强大的模式识别能力(如从原始图像中理解游戏画面)与强化学习的试错学习机制相结合,使得机器能够在复杂环境中(如围棋、电子游戏)从零开始,通过自我对弈和学习,最终达到甚至超越人类的巅峰水平(如AlphaGo)。

3)符号行为主义:虽然不如前两者知名,但也有研究者尝试用符号规则来指导行为主义的机器学习过程,以减少试错成本,提高学习效率。例如,给机器人一些预设的“安全规则”,让它在探索中避免危险行为。

2、当前现况:百花齐放,各司其职

1)符号主义:仍在特定领域(如法律、医学诊断、知识图谱等),扮演着不可或缺的“专家”角色,尤其在需要可解释性和精准逻辑的场景。

2)联结主义:毫无疑问是当前AI舞台的绝对主角,其深度学习技术几乎主导了所有感知任务,从我们的手机识别人脸,到智能音箱理解语音,再到ChatGPT生成流畅的文字,都离不开它的身影。

3)行为主义:在机器人、游戏AI和自主智能体领域持续突破,推动着机器在物理世界中变得更灵活、更自主。

3、未来趋势:通往通用智能的协奏曲

人工智能的未来,注定是一场多声部的协奏曲,而非单一乐器的独奏。

1)深度融合将是必然(Integrated Development):单一流派的局限性日益明显,只有将这三大流派的思想深度融合,才能真正实现具备人类水平智能的通用人工智能(AGI)。

2)可解释性与透明性(Explainability & Transparency)的追求:随着AI系统越来越深入我们的生活,理解机器的决策过程变得至关重要。如何让深度学习的“黑箱”变得透明,是未来研究的重点。

3)效率与能耗(Efficiency & Energy Consumption)的平衡:大型AI模型的训练和运行消耗巨大,未来需要更高效的算法和硬件,以实现可持续的AI发展。

4)常识推理(Common Sense Reasoning)的突破:赋予机器像人类孩子一样理解世界的常识能力,是实现真正智能的关键。

5)与人类共生(Coexistence with Humans):无论技术如何演进,AI的最终目标都应是服务人类社会,推动科学、经济与文化的进步,成为人类的得力助手,而非威胁。

6)伦理与安全(Ethics & Safety)的考量:随着AI能力不断增强,其潜在风险也日益凸显。制定健全的伦理规范和监管框架,确保AI发展造福人类而非带来危害,是全社会需要共同面对的挑战。

结语

人工智能的三大流派——符号主义、联结主义和行为主义——就像人类智能的不同侧面:符号主义让我们学会“思考”和“推理”,连接主义让我们学会“感知”和“识别”,行为主义则让我们学会“行动”和“适应”。它们共同构建了机器“思考”的宏伟蓝图。

或许,真正的通用人工智能(AGI),不会仅仅属于某一个“主义”,而是这三者加上未来更多新的思想,共同孕育出的璀璨结晶。我们将继续见证,机器如何在这些不同的智慧之路上,不断超越自我,走向更广阔的未来。

参考材料:

1:An Introduction to Symbolic AI

https://code-b.dev/blog/symbolic-ai

2:Symbolic Artificial Intelligence

https://weeklyreport.ai/primers/symai.pdf

3:Symbolic AI: Unveiling the Mechanics of Human-Like Reasoning

https://thomaswong.me/symbolic-ai

4:Symbolic Artificial Intelligence

https://www.opentrain.ai/glossary/symbolic-artificial-intelligence

5:Decoding Symbolic AI – In the World of Artificial Intelligence & Machine Learning

https://curiocial.com/symbolic-ai-neural-networks/

6:IBM Deep Blue

https://www.ibm.com/history/deep-blue

7:Connectionism wikipedia

https://en.wikipedia.org/wiki/Connectionism

8:Connectionism: history of artificial intelligence (AI)

https://www.britannica.com/science/history-of-artificial-intelligence/Connectionism

9:The Difference Between Symbolic AI and Connectionist AI

https://blog.re-work.co/the-difference-between-symbolic-ai-and-connectionist-ai/

10:What is neuro-symbolic AI?

https://www.techtarget.com/searchenterpriseai/definition/neuro-symbolic-AI

11:Neuro Symbolic AI: Enhancing Common Sense in AI

https://www.analyticsvidhya.com/blog/2023/02/neuro-symbolic-ai-enhancing-common-sense-in-ai/

12:Neuro-symbolic AI

https://en.wikipedia.org/wiki/Neuro-symbolic_AI

13:Prospects of AI in Architecture: Symbolicism, Connectionism, Actionism

https://openreview.net/pdf?id=gvHffM4DlpG

14:Converging Paradigms: The Synergy of Symbolic and Connectionist AI in LLM-Empowered Autonomous Agents

https://arxiv.org/pdf/2407.08516v3

15:Symbolic AI vs. Connectionist AI: Know the Difference

https://smythos.com/developers/agent-development/symbolic-ai-vs-connectionist-ai/

16:Geoffrey Hinton on revolutionizing artificial intelligence:https://www.youtube.com/watch?v=2EDP4v-9TUA

17:1957 The Birth of the First AI Program: The Logic Theorist

18:Brief History of Deep Learning from 1943-2019

https://machinelearningknowledge.ai/brief-history-of-deep-learning/

来源: 微信公众号

© 版权声明

1. 本平台所有原创文章(包括但不限于文字、配图、排版设计等原创内容),均遵循 知识共享署名 - 非商业性使用 4.0 国际许可协议(CC BY-NC 4.0) 对外授权,任何主体使用时需严格遵守协议约定。

2. 本平台转载文章的版权归原作者或原版权方所有,文中观点不代表本平台立场。本平台对文中陈述、观点判断保持中立,不对所包含内容的准确性、可靠性或完整性提供任何明示或暗示的保证。请读者仅作参考,并请自行承担全部责任。

3. 转载仅为传递行业资讯、实用知识等有益信息,不以盈利为目的;若涉及侵权,本平台在收到原方有效通知后将立即删文并配合处理,不承担额外法律责任。

4. 联系方式:hr@szsyw.cn

5. 微信公众号: 扫码关注

相关文章

没有相关内容!

暂无评论...